Attention – Be Carefull

Les exemples qui vont suivre ne sont qu’une base de travail. Il ne suffit pas de créer un modèle et se contenter de quelques résultats d’évaluations. C’est tout le paradoxe des réseaux de neurones qui ne peuvent donner un résultat (toujours avec une probabilité) que si celui-ci est parfaitement entrainé et testé. Dans le cas contraire Il peut donner des faux positifs ou négatifs (ex : un résultat vrai à 98% qui est complétement faux).

La validité d’un réseaux dépendra de la qualité du Data Set, du type de modèle, de son Accuracy qui doit tendre vers 100%, de son Loss ainsi que son Overfitting qui doivent tendre vers zéro.

Il existe différentes méthodes et théories pour la mise au point des réseaux de neurones en fonction du problème abordé. Il est impossible ici de les détailler. Le Deep Learning est en constante évolution et je ne peux que vous invitez à scruter le Net pour vous informer.

En conclusion, le Deep Learning n’est pas la panacée universelle et il faut l’aborder avec prudence.

Index.

- 1) Base de la création de réseaux neuronique supervisés pour la classification d’images (MNIST Fashion).

- 2) Base de la création de réseaux neuronique supervisés pour la classification d’images (Dogs vs. Cats) DataSet Kaggle.

- 3) Base de la création d’un réseau neuronique R-CNN pour la détection d’objets.

- 4) Base Autoencoder (AE) & Variational Autoencoder (VAE) – Non Supervisé.

1) Base de la création de réseaux neuronique supervisés pour la classification d’images (MNIST Fashion).

Ce qui suit est quasi une phase incontournable pour débuter en Deeplearning et en particulier pour les utilisateurs de Tensorflow (API – IA de Google). Le but est, à partir d’un réseau relativement simple, de créer et d’entrainer un réseau de neurone supervisé capable d’effectuer une classification d’images provenant à l’origine du catalogue Zalando. Le Data Set utilisé (MNIST Fashion) contient un ensemble d’images en noir et blanc de (28x28) pixels. Vous trouverez sur le Net un nombre incalculable d’exemples basés sur ce Data Set.

Ps : Pour ma part (ma vue personnel), j’ai essayé de monter et d’illustrer en détail les différentes phases nécessaires pour réaliser ce type d’application de base.

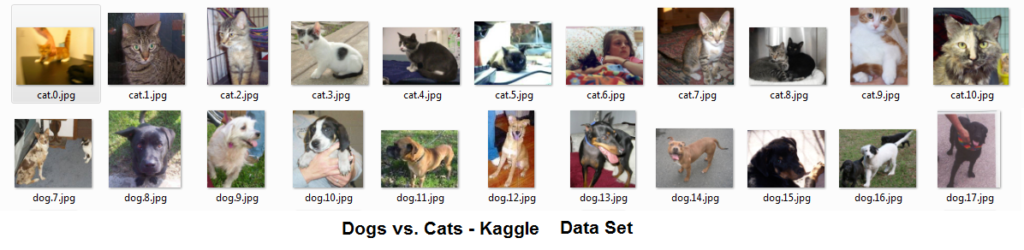

2) Base de la création de réseaux neuronique supervisés pour la classification d’images (Dogs vs. Cats) DataSet Kaggle.

Ce réseau CNN est également un incontournable pour débuter en Deeplearning. L'ensemble des données Dogs vs. Cats fait référence à un ensemble de données utilisée pour un concours d'apprentissage automatique Kaggle en 2013. Le DataSet est constitué de 25000 photos couleur labellisées de format divers (ex : dog.2899.jpg – cat.1137.jpg) et d’un DataSet de test de 12500 images couleur non labellisées (ex : 2518.jpg).

Dans cet exemple nous utiliseront des modèles CNN de type VGG16. Ce type de modèle est un modèle de réseau de neurones convolutif proposé par K.Simonyan et A.Zisserman de université Oxford. Ce type de modèle est censé être capable de donner une Accuracy supérieure à 90+%.

Ps : Ce type de modèle est plus sophistiqué et utilise des fonctionnalités de haut niveau de l’API Keras. Pour ma part (ma vue personnel), j’ai utilisé plusieurs variantes du modèle VGG16 et j’ai essayé de manière didactique d’illustrer en détail les différentes phases nécessaires pour réaliser ce type d’application.

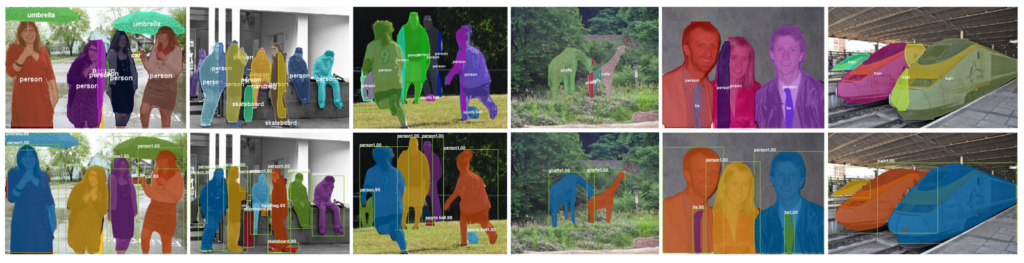

3) Base de la création d’un réseau neuronique R-CNN pour la détection d’objets.

Le réseau R-CNN ou (Region Based Convolution Neural Networks), est un réseau conçu pour la détection d’objets par l’utilisation de Mask (masque pré-calculé).

Jusqu’à présent nous avons étudié des modèles CNN de base. Dans l’article qui va suivre nous allons vraiment passer à la vitesse supérieure par l’étude et la réalisation d’un modèle beaucoup plus complexe.

A.S.A.P

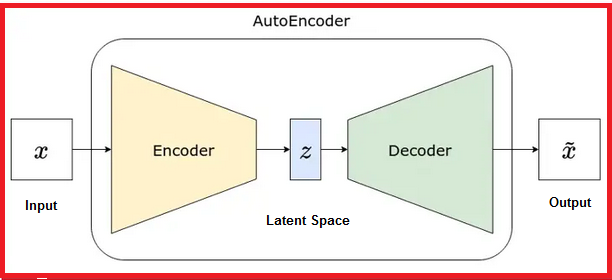

4) Base Autoencoder (AE) & Variational Autoencoder (VAE) - Non Supervisé

Un réseau autoencodeur est un type de réseau de neurones artificiels utilisé pour l'apprentissage non supervisé de représentations de données. Il est composé de deux parties principales : l'encodeur et le décodeur et une zone intermédiaire Z de latence.